La Marina de los EE. UU. está desarrollando submarinos controlados por sistemas de Inteligencia Artificial, que podrían tener la capacidad de matar sin control humano. El proyecto se llama CLAWS y está dirigido por la Oficina de Investigación Naval, responsable de los programas de ciencia y tecnología de la Armada y el Cuerpo de Marines.

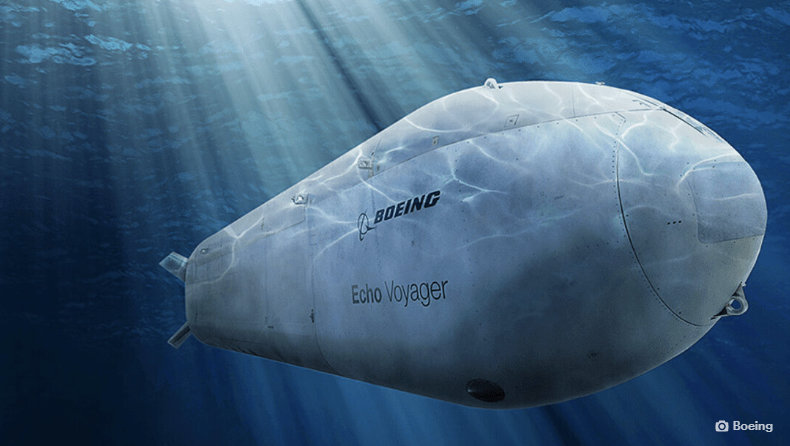

Los documentos presupuestarios descubiertos por New Scientist describen a CLAWS como un «sistema autónomo de armas submarinas no tripuladas» que podría instalarse en robots submarinos como el vehículo submarino Orca desarrollado por Boeing. Estas embarcaciones estarán armadas con 12 tubos de torpedos que podrían ser controlados por CLAWS sin ninguna intervención humana. «Extenderá clandestinamente el alcance de grandes UUVs [vehículos submarinos no tripulados] y aumentará las áreas de misión a efectos cinéticos», se lee en los documentos.

CLAWS fue revelado por primera vez en 2018 como un intento de «mejorar la autonomía y la supervivencia de los vehículos submarinos no tripulados grandes y extra grandes». Sin embargo, hasta ahora no se conocía su capacidad armamentística. El presupuesto asignado ahora se utilizará para desarrollar la idea en un prototipo funcional.

Estados Unidos no está solo trabajando en submarinos autónomos. Los científicos chinos esperan desplegar en esta década submarinos militares no tripulados en los océanos del mundo. Aunque la decisión final sobre atacar aún será tomada por comandantes humanos, por ahora, los desarrollos sugieren que se está abriendo un nuevo frente en la carrera armamentista de la IA en el mar.

IA sin control, un problema planetario

Stuart Russell, profesor de ciencias de la computación en la Universidad de California, describe CLAWS como un «desarrollo peligroso». No es para menos. «Equipar un vehículo totalmente autónomo con armas letales es un paso significativo y corremos el riesgo de una escalada accidental imparable», explicó a New Scientist.

La tecnología avanza rápidamente y el sector de la robótica con ella, con una inversión de 16.500 millones de dólares en 2018 tras un gran crecimiento. Entre ellos se incluyen estos ‘robots asesinos’ que desde la ciencia ficción serán toda una realidad, en la que robots o drones voladores, nadadores o ambulantes pueden equiparse con sistemas de armas letales, misiles, bombas o armas de fuego, que podrían programarse para operar total o parcialmente de manera autónoma.

Múltiples organizaciones están en contra de esta escalada usando tecnología tan poderosa como la Inteligencia Artificial. Hace dos años un comité de las Naciones Unidas estableció un programa de negociaciones para definir los límites de los denominados «robots asesinos», es decir, las armas capaces de matar sin intervención de los humanos.

El uso de ‘sistemas de armas autónomas letales’ plantea una serie de nuevas cuestiones éticas que los gobiernos deben considerar con urgencia y desde las mismas tecnológicas como Microsoft se recomienda una regulación. No ha sido el único. El multimillonario sudafricano presidente de SpaceX o Tesla, Elon Musk, aseguró que la Inteligencia Artificial era la mayor amenaza existencial de la humanidad.

Las declaraciones de Musk contra las tecnologías de IA o para ser más precisos, su pesimismo en cuanto al uso que los humanos daremos a ellas, van más allá de las acciones de los líderes humanos, ya que piensa que gran guerra podría ser iniciada por una computadora inteligente que calculase un ataque como la mejor opción (tipo Skynet en Terminator) como estos submarinos militares autónomos con capacidad para equipar bombas nucleares. «Una vez desarrolladas, las armas letales autónomas bajo una IA sin control, van a permitir conflictos armados en una escala mayor que nunca, y en tiempo más rápido que los humanos puedan comprender. No tenemos tiempo para actuar. Una vez que se abra la caja de Pandora, será difícil de cerrar», explican los críticos contra este tipo de desarrollos.

No hay comentarios:

Publicar un comentario